AIGC产品的生命周期透视(上)数据与代码的授权合规

AIGC产品的生命周期透视(上)数据与代码的授权合规

引言

此前笔者在《以全球主流AIGC产品用户协议为例梳理AIGC生成内容的权利归属与使用限制 》中就AIGC产品生成内容合规提出建议,结合已于2023年8月15日正式施行的《生成式人工智能服务管理暂行办法》(以下简称“《办法》”),本文将从AIGC产品生命周期剖析AIGC产品在0到1过程中的合规风险,为AIGC产品合规提供有益借鉴。

一、AIGC产品的诞生

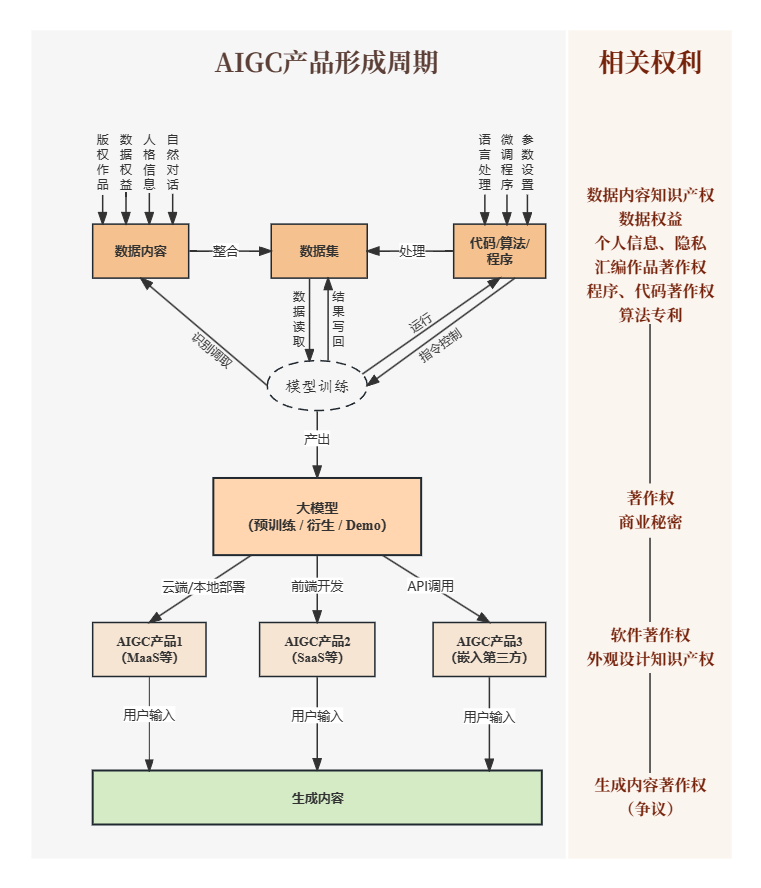

点击可查看大图

正如前图所展示,AIGC产品从0开始到训练模型、到形成大模型、到AIGC产品、最终到收到用户指令输出生成内容,整个生命周期将历经6个重要风险合规要点。

1、数据内容。数据内容是用于模型学习的具体信息的总称,例如用于自然语言处理训练的人类对话语料文本、用于人工智能生成图像训练的画作、照片等。除少数不承载任何个性化信息或智力成果的内容外,绝大多数数据内容受到法律保护,涉及著作权、隐私权、肖像权、个人信息权益、数据权益以及其他财产权益。

2、数据集。数据集是对数据内容进行归集后形成的用于模型学习的大体量信息集合。目前主流的大模型训练所用的数据集一般包括十亿以上文本单位(Token),少数可达万亿文本单位级别。[1]ChatGPT的基础模型GPT-3训练所用的数据集中,有60%来自于开放数据网站Common Crawl在2016-2019年间随机爬取的全球互联网信息网页快照形成的数据集,其原初体量高达45TB,经过筛选和清洗后,最终用于训练的高质量数据集仍有570GB。[2]高质量的数据集可能作为汇编作品受到著作权法保护,数据集提供者享有相应著作权。

3、代码、算法与程序。既包括搭建大模型的程序、命令时撰写的基本代码和应用的算法,也包括在搭建模型功能时所调用的各类调试工具、模型、程序等。例如在搭建模型时常用的指令分词的分词器(Tokenizer)程序,典型代表是谷歌开源的SentencePiece模型[3];再如对大模型参数增加附加层实现针对特定领域微调的PEFT技术,典型代表是微软开源的LoRA模型[4]。前述模型在大模型的自然语言处理环节和调试内容产出环节能够发挥重要作用。这些代码、模型可能作为计算机程序而受到著作权法保护,算法可能作为数据处理或信息分析的方法发明专利受到专利法保护,非公开内容亦可能作为商业秘密受到保护。

4、大模型。大模型是通过特定算法架构对数据集进行深度学习后形成的独立的程序,通过大规模参数赋予其回应指令、解决问题的技能,生成符合指令的结果。一般认为,一个模型完成预训练后即可被归入大模型范畴,此后经过微调(Fine-tune)、优化和修改,再衍生出各类产出内容精确度更高、更符合使用者需要的各类衍生大模型或Demo版本。大模型是AIGC产品形成流程中的核心权利节点,目前广为人知的大模型包括OpenAI公司的GPT系列模型(其中,ChatGPT就是基于GPT-3.5微调而成),Meta公司的LlaMA系列模型,清华大学的GLM-130B模型,以及百川公司最新发布的Baichuan-17B模型等。大模型可能作为作品受到著作权法保护,亦可能作为商业秘密受到保护。

5、AIGC产品。基于大模型形成的,经过前端代码开发或通过API接口而形成的,能够供用户直接使用的程序、软件、云端的MaaS(模型即服务)或SaaS(软件即服务)。例如OpenAI基于GPT-3.5模型开发出的ChatGPT聊天程序在chat.openai.com上向用户开放,用户只要注册并同意使用条款后就可以在该页面与ChatGPT进行对话;同时其模型亦通过开放API接入在线笔记应用Notion形成Notion AI[5],使Notion的用户可以使用GPT模型优化笔记内容。AIGC产品作为一个完整的软件或程序,在大模型本体之外仍有大量功能开发等代码,其完整形态可作为计算机软件受到著作权法保护,相应的用户界面设计、显示屏幕面板、界面视图等还可能作为外观设计专利获得保护。

6、生成内容。用户向AIGC产品输入自然语言指令后,由AIGC产品通过模型处理输出的生成内容。目前主流AIGC产品的生成内容已涵盖各题材文本、图像、画作、代码、视频等。有些大模型尚未开发出AIGC产品,但有一定计算机技能的工程师也可以在特定配置环境中调用其源代码生成内容。AIGC生成内容是否构成著作权法意义上的“作品”是国内外讨论激烈的话题。本文笔者认为,AIGC生成内容有可能作为作品获得著作权法保护(具体讨论可参见笔者《ChatGPT的著作权规制 》一文),并将以此为基点展开后文讨论。简言之,AIGC生成内容可能产生著作权等知识产权权益,值得严肃对待。

二、数据内容的授权合规

1、数据内容的风险

当前,部分数据内容的收集欠缺相关制度规范,处于野蛮生长阶段,大量数据内容在权利人不知情的情况下被机械爬取、复制进入数据集。此类爬取和复制行为处于民事侵权乃至刑事犯罪的灰色地带,以至于最终形成的数据集在来源合规方面也存在较高风险。例如,某些数据集可能完整复制了某作者在某网站上发布的文章、某艺术家发布并禁止转载的画作、某社交软件用户在交谈中透露的个人信息等。这些数据内容的访问和复制往往未经权利人许可,存在侵犯著作权、个人信息权益、肖像权之虞。

2023年1月至2月,某国际大型版权图片提供商在美国和英国先后对AI绘画公司Stability AI提起诉讼,认为被告在训练旗下的图片生成模型Stable Diffusion时擅自复制了120万张版权照片及其题注文字、元数据用于训练。[6]7月,三位美国作家对OpenAI[7]和Meta[8]分别提起集体诉讼,认为两公司擅自复制了其作品,用于GPT大模型和LlaMA大模型训练。上述诉讼同时附带商标权侵权、违约、不正当竞争等指控,原告提出要求被告停止侵权、删改所有涉及权利作品的数据内容及生成内容等诉求,在赔偿方面分别主张应得利益损失或惩罚性赔偿等。

此外,数据收集的个人信息,不仅包括以文本或数字形式出现的用户在互联网平台上公开的个人信息,还可能涉及个人照片、声音、手写字迹等高度敏感的生物识别信息。这些信息往往在权利人不知情的情况下被爬取和使用,且欠缺通知和退出机制。2023年6月28日,美国16名原告对OpenAI提起集体诉讼,认为其从社交网站抓取用户的个人信息、视频、音频等用于模型训练违反了美国《联邦电子通讯隐私法案》、伊利诺伊州《生物识别信息隐私法》等。[9]除此之外,还有一种常见的数据内容收集方式,即从商业机构处购买用户个人信息。但是除非用户对此明确知情且同意,否则该行为仍有超出个人信息处理的正当、必要范围原则的合规风险。

机械抓取的数据内容中可能存在虚假、非法、偏见、歧视、危害身心健康等负面内容。如果未经清洗和筛选就将上述内容用于模型训练,很可能对模型及AIGC产品的最终效果产生不利影响。例如,2016年3月发生的某AI机器人“被教坏”事件:人工智能机器人“Tay”通过与用户在社交媒体上互动进行实时机器学习并作出回应,将真人用户输入的信息自动纳入数据集并进行学习反馈,最终导致其在上线后十几个小时就开始对外发表种族主义、极端主义言论,最终被下架。

2、数据内容的授权合规路径

(1) 权利自持:生成原创数据内容开展训练

通过生成原创的数据内容训练模型,可以将模型开发中的数据合规风险降低,从根源上把控模型及后续产品合规。尽管以目前的模型体量来看,全原创数据难以满足大模型预训练所需的数据量级,但仍有望用于训练小体量模型或模型微调。例如,2023年4月12日Databricks发布的Dolly 2.0模型在基于开源模型EleutherAI pythia系列上进行人工指令微调,该微调所用的数据集全部来自该公司5000名员工在2023年3月至4月原创撰写的15000个高质量文本素材。[10]这一例子展示了通过原创数据避免权利瑕疵的可能。

此外,高质量的原创数据也可以对数据内容的整体价值起到积极效果,产生小数据集撬动大模型的效果。随着算法、模型的优化和数据资源开发枯竭,未来的模型训练也可能走向数据体量浓缩化,通过权利自持的原创数据内容进行模型训练将具备更高的实用价值。

(2) 授权使用:向数据内容权利人获取授权

模型开发者可以先从权利人处获得合法授权,再将相关信息和内容用于模型训练。拥有社交平台类产品的企业可以将授权条款写入用户协议,从而获取相应授权,以便使用其用户在平台上传、发布的信息训练模型。

应当注意的是,采取此种方式获得授权应遵循格式条款有关规范。考虑到用户在平台上传的内容既可能涉及著作权、肖像权,又可能涉及个人信息乃至敏感信息(例如人脸特征),因此这类授权条款的设计需要审慎考量。从合规角度考虑,有必要根据《民法典》第496条第2款之规定,采取合理方式履行提示或者说明义务,例如设置强制弹窗勾选程序等。此外,如涉及敏感信息收集,还应适当限缩相关授权权限范围。最高人民法院“法释〔2021〕15号”司法解释明确规定,通过格式条款获得授权收集人脸信息的,不得为无限期、不可撤销、可任意转授权等授权形式,否则该条款无效。在获取授权后,开发者处理个人信息同样应遵循个人信息相关保护规范,有必要配置告知同意程序和通知删除功能。

对于适用于特定场景的定向模型,开发者可与数据持有人合作,由数据持有人提供数据集并对数据内容作权利无瑕疵保证。2017年,某大型互联网公司与生物科技公司Adaptive合作开发基于血液检测的免疫系统信息解码模型,其训练所用的数据全部来自于Adaptive提供的生物和医疗信息并作权利无瑕疵保证。[11]

(3) 数据清洗:对数据内容进行清洗和优化

《办法》第七条明确,生成式人工智能服务提供者在训练数据处理时应采取有效措施增强训练数据的真实性、准确性、客观性、多样性。在数据筛选和清洗的过程中,相关服务的提供者可以增加合规处理环节,去除违法、虚假、歧视内容,对敏感个人信息进行脱敏处理,对文字作品、视听作品等著作权客体采取摘要、引用等方式纳入数据集。上述做法既有助于提高数据内容质量,也可有效降低合规风险。目前,国际领先的大公司已开始重视在大模型训练中加强数据内容合规处理。例如,Meta公司在2023年7月19日发布大模型LLaMA-2时即表示,该公司在预训练前清洗并排除了数据集中已知的来自含有大量个人隐私信息的网站的数据,以强化LLaMA-2模型的安全性,避免侵犯他人信息和隐私安全。[12]

三、数据集/代码的授权合规

1、数据集/代码开源的风险

得益于信息技术社区的开放共享传统,目前市面上存在大量的开源模型、代码、工具,为大模型和AIGC产品研发日新月异的进展铺路赋能。也正因如此,许多开发者选择基于既有的数据集、代码、预训练模型等建立或调试自己的大模型。在调用他人成果时,应格外注意是否属于他人成果的许可条款授权范围,避免因违反许可协议而产生违约或侵权责任。

非开源的工作成果往往要求后续开发者单独签署许可协议以获取授权,合同明文规定使许可内容和范围更加清晰明确,也方便当事人知晓并遵守合同中的重要事项;而在开源社区中,许可协议往往仅以“License.txt”为名悄然列于项目文件列表,使用者如果不慎忽视就将面临重大法律风险。开源许可协议种类繁多,模板化的开源协议集群例如MIT,BSD,GPL,Apache,CC等;每个集群下又有若干协议版本,例如GPL集群下的AGPL,LGPL,CC集群下的CC BY-SA等。开发者也可能设置个性化的开源协议,代表如为GPT提供绝大多数自然语言训练语料的Common Crawl数据集、Meta公司开源的LLaMA-2大模型都发布了个性化的许可协议。开源协议的形态或显繁杂,但万变不离其宗。模型开发者在查询开源协议/许可证时应重点注意以下风险要点。

(1) 是否可修改/改编

是否可修改/改编决定着能否调用该数据集和代码用于个人模型开发。在调用数据集和代码来建立或调试个人模型时,往往会调整原数据集或代码的应用范围、参数等,但如果许可证中不包括可修改,意味着前述调整都将超出许可范围;同理,如果许可证中不包括可改编(Derivative),意味着他人无权调用该数据集或代码建立或调试个人模型,也不能从原模型基础上转换、调整、混合出Demo版本。

(2) 是否可商用

是否可获得商用许可决定了某一开源工具能否超越科研领域而用于营利目的。尽管开源,许多数据集、模型、工具禁止商业使用,例如清华大学的GLM-130B模型、斯坦福大学的Alpaca-7B模型。部分版本的开源协议也直接排除了商业使用许可,例如CC集群下带有“NC”(Non-commercial)标志的协议均意味着非商用。如果开发者调用了不可商用的许可协议下的数据集和代码,由此产生的模型就仅能以非营利的方式使用。

(3) 是否传染与强制开源

开源协议的“传染”是指,调用了此类协议的开源数据集或代码形成的工作成果必须以相同开源协议对外分发,且首先意味着强制开源。典型的传染性开源协议如GPL、Mozilla,以及CC协议集群中带有“SA”(Share Alike)标志的协议。传染性使得部分商业开发者对开源软件望而却步,例如谷歌规定不得将AGPL开源协议的软件用于公司工作,防止谷歌的代码被强制开源。[13]除强制开源之外,不同开源协议的传染性亦有所差异,例如GPLv2协议要求后续程序以相同协议分发且所有条款不得增删变更,而GPLv3则只要求核心条款不得变更,但允许使用者增删其他条款,例如附加免责条款。

(4) 是否存在非竞争条款

基于开放共享的理念,主流开源协议大多不含非竞争条款,但在个性化的开源协议中,非竞争条款却愈发常见。例如,OpenAI的使用条款中要求使用者不得将OpenAI的输出结果用于开发与其有竞争关系的模型;[14]再如,LLaMA-2虽是开源、可商用的模型,但其许可协议同样限制不得将LLaMA-2的代码、生成内容及其他输出结果用于改进任何其他大模型(LLaMA-2的衍生模型除外)。[15]

2、数据集/代码的授权合规路径

(1) 查看许可协议并遵照执行

为尽可能控制法律风险,建议模型开发者在调用他人数据集、代码、模型、工具前首先查看许可协议,明确可获得的授权范围。在调用多个数据集、代码的情形下,还应注意不同许可协议的兼容问题,例如GPLv2协议与Apache 2.0协议不兼容,因为Apache 2.0缺少前者要求的某些专利中止与侵害保护条款;[16]再如,两个不同的传染性许可协议也可能导致适用冲突。开发者可以在开源协议组织者的官网查询许可协议的兼容情况。

(2) 采取技术手段隔绝传染性

开发者如果既想调用具有传染性的开源协议下的代码或数据集,又希望规避掉传染性要求,则可以考虑采取一定开发或技术手段平衡商业需要并降低法律风险。

在开发端,可考虑采取“净室方法”(Cleanroom approach)隔绝传染性,该方法最早由IBM公司提出,基本内容是安排两组团队,团队一负责代码编写但不阅读有传染性的源代码,团队二阅读源代码、研究其原理并向团队一说明,但不参与任何开发和代码编写工作。前述过程同时安排律师进行监督。[17]这一方法基于著作权法仅保护表达而不保护思想或方法的基本原理,通过隔绝开发团队与传染性代码的接触以免受传染性许可协议约束。在技术端,也可以考虑采用封装代码、管道通信等技术方式对调用代码和自建代码实现静态或动态隔离,以降低因代码传染而被迫开源的法律风险。

(3) 前溯检查他人代码调用来源

在调用他人代码时,也应前溯检查他人代码是否调用了外部URL和数据包,以避免因他人代码调用侵权资料而受牵连。例如2019年“阿里巴巴公司与荣耀公司‘掌上小说’ APP著作权侵权纠纷案”中,被告调用了一段开源代码,该代码被解码后发现其实际调用了侵权数据内容,法院最终判决调用该开源代码的被告同样构成著作权侵权。

四、小结与预告

在生成式人工智能迅猛发展的当下,风险与挑战也正悄然而生。在这场长期且颠覆性的技术竞争中,只有于方兴未艾之际预判并控制风险,才能行稳致远。本文对AIGC产品形成过程的数据内容、数据集和代码的相关授权合规提供借鉴。下篇中,笔者将进一步探讨大模型、AIGC产品、AIGC内容的合规路径,以期更好助力中国大模型和AIGC产品行业的蓬勃发展。

[注]

[1] GenAI, Meta. (2023). Llama 2: Open Foundation and Fine-Tuned Chat Models. P.20. https://scontent.fhkg3-1.fna.fbcdn.net/v/t39.2365-6/10000000_662098952474184_2584067087619170692_n.pdf?_nc_cat=105&ccb=1-7&_nc_sid=3c67a6&_nc_ohc=RYfzDCymkuYAX-Sq5_b&_nc_ht=scontent.fhkg3-1.fna&oh=00_AfDu7ph4Nn-a3xUmrpt5rpG9TZqsp1sJ8VeyWtFFLw8YqQ&oe=64C25B7F

[2] Brown, T., Mann, B., Ryder, N., Subbiah, M., Kaplan, J., & Dhariwal, P. et al. (2020). Language Models are Few-Shot Learners. P.8. Retrieved 17 July 2023, from https://arxiv.org/abs/2005.14165

[3] Google. (2023). GitHub - google/sentencepiece: Unsupervised text tokenizer for Neural Network-based text generation. Retrieved 17 July 2023, from https://github.com/google/sentencepiece

[4] Microsoft. (2023). GitHub - microsoft/LoRA: Code for loralib, an implementation of "LoRA: Low-Rank Adaptation of Large Language Models." Retrieved 17 July 2023, from https://github.com/microsoft/LoRA

[5] Notion AI Supplementary Terms. (2023). Retrieved 24 July 2023, from https://www.notion.so/Notion-AI-Supplementary-Terms-fa9034c8b5a04818a6baf3eac2adddbb

[6] Complaint. Getty Images v. Stability AI. (2023). https://aboutblaw.com/6DW. Retrieved 24 July 2023.

[7] Class Action Complaint. S. Silverman et al. v. Open AI. (2023). https://www.documentcloud.org/documents/23869693-silverman-openai-complaint

[8] Class Action Complaint. R. Kadrey et al. v. Meta Platforms. (2023). https://llmlitigation.com/pdf/03417/kadrey-meta-complaint.pdf

[9] Class Action Complaint. P. M. et al. v. Open AI. (2023). https://clarksonlawfirm.com/wp-content/uploads/2023/06/0001.-2023.06.28-OpenAI-Complaint.pdf

[10] Free Dolly: Introducing the World's First Truly Open Instruction-Tuned LLM. (2023). Retrieved 18 July 2023, from https://www.databricks.com/blog/2023/04/12/dolly-first-open-commercially-viable-instruction-tuned-llm

[11] Lee, P. (2018). M* and Adaptive Biotechnologies announce partnership using AI to decode immune system; diagnose, treat disease - The Official M* Blog. Retrieved 18 July 2023, from https://blogs.microsoft.com/blog/2018/01/04/microsoft-adaptive-biotechnologies-announce-partnership-using-ai-decode-immune-system-diagnose-treat-disease/

[12] GenAI, Meta. (2023). Llama 2: Open Foundation and Fine-Tuned Chat Models. P.20. https://scontent.fhkg3-1.fna.fbcdn.net/v/t39.2365-6/10000000_662098952474184_2584067087619170692_n.pdf?_nc_cat=105&ccb=1-7&_nc_sid=3c67a6&_nc_ohc=RYfzDCymkuYAX-Sq5_b&_nc_ht=scontent.fhkg3-1.fna&oh=00_AfDu7ph4Nn-a3xUmrpt5rpG9TZqsp1sJ8VeyWtFFLw8YqQ&oe=64C25B7F

[13] AGPL Policy | Google Open Source. (2023). Retrieved 23 July 2023, from https://opensource.google/documentation/reference/using/agpl-policy

[14] Open AI Terms of use. (2023). Retrieved 23 July 2023, from https://openai.com/policies/terms-of-use

[15] Facebookresearch. (2023). llama/LICENSE at main · facebookresearch/llama. Retrieved 23 July 2023, from https://github.com/facebookresearch/llama/blob/main/LICENSE

[16] Various Licenses and Comments about Them - GNU Project - Free Software Foundation. (2023). Retrieved 23 July 2023, from https://www.gnu.org/licenses/license-list.html#GPLCompatibleLicenses

[17] R. C. Linger and H. D. Mills, "A case study in cleanroom software engineering: the IBM COBOL Structuring Facility," Proceedings COMPSAC 88: The Twelfth Annual International Computer Software & Applications Conference, Chicago, IL, USA, 1988, pp. 10-17, doi: 10.1109/CMPSAC.1988.17141